6 prácticas que quedan prohibidas con la ley de gobernanza de la Inteligencia Artificial

La norma sobre la que trabaja el Gobierno prohíbe la manipulación subliminal, la explotación de vulnerabilidades y la discriminación biométrica, con multas de hasta 35 millones de euros para garantizar un uso ético y seguro de la IA en España.

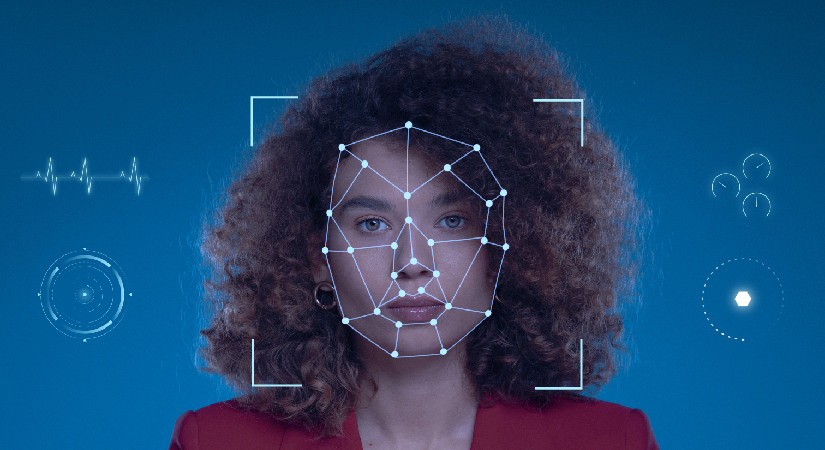

Los sistemas de reconocimiento facial quedarán prohibidos según la ley en la que trabaja el Gobierno. Imagen generada con inteligencia artificial.

Cámarabilbao

El Gobierno de España ha aprobado el anteproyecto de ley de gobernanza de la Inteligencia Artificial (IA), con el objetivo de asegurar un uso ético, inclusivo y beneficioso de esta tecnología para la sociedad. Esta nueva normativa, sobre la que está trabajando el Ejecutivo y que se tramitará por la vía de urgencia, adapta el marco legal español al reglamento europeo sobre IA, ya en vigor, combinando la protección de derechos con el impulso a la innovación tecnológica.

La norma europea establece un marco legal común para el desarrollo, la comercialización y el uso de sistemas de IA, con el fin de minimizar riesgos para las personas. Prohibirá la utilización de esta tecnología con el fin de manipular la toma de decisiones, explotar vulnerabilidades de grupos sociales y colectivos o clasificar biométricamente a individuos. Además, obligará a identificar los contenidos creados con Inteligencia Artificial, fijando multas de hasta 35 millones de euros para quienes vulneren la norma.

El Ministro de Transformación Digital y de la Función Pública, Óscar López, destacó este martes en la rueda de prensa posterior al Consejo de Ministros que “la IA puede ser utilizada para investigar el cáncer o el Alzheimer, para prevenir catástrofes naturales, para descubrir nuevos medicamentos; o puede ser usada para difundir bulos y mentiras, esparcir odio y atacar a nuestra democracia. Por eso es oportuno su buen uso y gobernanza”.

¿Qué prácticas prohibirá la norma?

Además de la obligación de identificar los contenidos generados con la Inteligencia Artificial, la norma sobre la que está trabajando el Gobierno incluye seis prácticas más que quedarán prohibidas:

1.- Prohibición del uso de técnicas subliminales para la manipulación conductual sin consentimiento

Queda expresamente prohibido el empleo de técnicas subliminales, como imágenes, sonidos u otros estímulos imperceptibles, que tengan como objetivo influir en las decisiones o comportamientos de las personas sin su conocimiento o consentimiento, especialmente cuando dichas prácticas puedan derivar en perjuicios significativos. Entre estos daños se incluyen, pero no se limitan a, la generación de adicciones, la pérdida de autonomía personal, la exposición a situaciones de violencia o cualquier otro tipo de afectación grave a los derechos y libertades individuales.

Un ejemplo de esta prohibición sería el uso de un asistente virtual equipado con inteligencia artificial que, tras detectar patrones de comportamiento asociados a la adicción al juego, emita mensajes subliminales dirigidos a incitar a la persona a regresar a una plataforma de apuestas online. Este tipo de prácticas, al operar de manera encubierta, no solo vulneran la capacidad de decisión consciente de los individuos, sino que también pueden exacerbar problemas de salud mental y bienestar.

2.- Protección de personas vulnerables frente a la explotación de sus condiciones personales

La ley establece una protección especial para aquellos colectivos considerados vulnerables, como menores de edad, personas con discapacidad o individuos en situaciones socioeconómicas desfavorecidas, prohibiendo el uso de sistemas tecnológicos que se aprovechen de sus condiciones para modificar su comportamiento de manera perjudicial. Esta medida busca evitar que las vulnerabilidades inherentes a estos grupos sean explotadas con fines comerciales, manipulativos o de cualquier otra índole que pueda generar consecuencias negativas para su integridad física, emocional o económica.

Un caso práctico que quedaría vetado sería el de un posible juguete inteligente equipado con inteligencia artificial que, mediante interacciones aparentemente inocuas, desafíe a niños pequeños a realizar pruebas peligrosas o arriesgadas, exponiéndolos a posibles lesiones físicas o traumas psicológicos.

3.- Prohibición de la clasificación biométrica discriminatoria

Se prohíbe el uso de tecnologías biométricas, como el reconocimiento facial, para clasificar a las personas en función de criterios discriminatorios, tales como su raza, religión, ideología política, orientación sexual u otras características protegidas por ley. Esta medida busca evitar que la inteligencia artificial perpetúe o amplifique prejuicios sociales, contribuyendo a la estigmatización o exclusión de determinados grupos.

Por ejemplo, quedarían prohibidos los sistemas de reconocimiento facial que analizan imágenes publicadas en redes sociales para etiquetar a las personas según su ideología política o preferencias sexuales, ya que este tipo de prácticas no solo violan la privacidad individual, sino que también pueden ser utilizadas para fines de vigilancia masiva, discriminación laboral o exclusión social.

4.- Veto a la asignación de puntuaciones sociales basadas en comportamientos o características personales

La norma prohíbe la implementación de sistemas que evalúen, puntúen o clasifiquen a personas o colectivos en función de aspectos como su estilo de vida, hábitos, relaciones personales o entorno social, con el fin de condicionar su acceso a servicios, beneficios o oportunidades. Esta medida busca evitar que la tecnología se utilice como herramienta de control social, limitando derechos fundamentales como la libertad de expresión, la privacidad y la igualdad de oportunidades.

Un ejemplo de práctica prohibida sería el uso de algoritmos que denieguen préstamos o servicios financieros a individuos por tener una “baja puntuación social”, determinada en base a sus publicaciones en redes sociales, su círculo de amistades o su lugar de residencia. Este tipo de sistemas no solo perpetúan desigualdades estructurales, sino que también pueden generar un clima de desconfianza y exclusión social.

5.- Limitación de la evaluación del riesgo de criminalidad basada en datos personales sin justificación legal

Se considera ilegal el uso de información personal, como el entorno familiar, el nivel educativo, el barrio de residencia o los antecedentes familiares, para predecir la probabilidad de que una persona pueda cometer un delito, salvo en los casos expresamente permitidos por la ley y bajo estrictos controles de transparencia y proporcionalidad. Esta medida busca evitar que la tecnología se utilice para estigmatizar a individuos o grupos en función de características ajenas a su conducta real, garantizando que las decisiones judiciales o policiales se basen únicamente en pruebas individualizadas y no en prejuicios algorítmicos.

Por ejemplo, quedaría prohibido un sistema predictivo policial que etiquete como “sospechosas” a personas por vivir en determinadas zonas o por tener familiares con antecedentes penales, sin una evaluación caso por caso que justifique dicha sospecha.

6.- Restricciones al uso de la detección emocional en contextos laborales y educativos

La ley prohíbe el uso de tecnologías de detección emocional, como el análisis de expresiones faciales o tonos de voz, para evaluar a empleados o estudiantes con fines de promoción, despido o calificación, excepto en casos específicos relacionados con la seguridad o la salud. Esta medida busca proteger la privacidad y la dignidad de las personas, evitando que sus emociones sean monitoreadas y utilizadas en decisiones que afecten su vida laboral o académica.

Un ejemplo de práctica prohibida sería un programa que registre las expresiones faciales de los empleados durante una reunión para medir su “motivación” o “compromiso”, y utilice esos datos como criterio para decisiones de ascenso o despido.

Sanciones y multas por incumplimiento

Las prácticas prohibidas entraron en vigor el 2 de febrero, aunque no se sancionarán hasta el 2 de agosto. Los incumplimientos podrán conllevar multas o medidas correctoras, como la obligación de modificar el sistema para hacerlo legal o impedir su comercialización. Estas sanciones se aplicarán según lo previsto en el régimen sancionador incluido en el anteproyecto de ley y conforme a los márgenes establecidos por el reglamento europeo.

Las sanciones económicas para estos casos pueden oscilar entre 7,5 y 35 millones de euros, o entre el 2% y el 7% del volumen de negocio global del infractor en el ejercicio anterior, aplicándose la cuantía mayor. Para las pequeñas y medianas empresas (pymes), se aplicará la menor de las dos cifras.

La vigilancia del cumplimiento de estas normas estará a cargo de distintas autoridades según el ámbito:

- Agencia Española de Protección de Datos, en lo relacionado con sistemas biométricos y control fronterizo.

- Consejo General del Poder Judicial, para sistemas de IA aplicados en el ámbito judicial.

- Junta Electoral Central, en casos que afecten a procesos democráticos.

- Agencia Española de Supervisión de la Inteligencia Artificial, para el resto de aplicaciones.